VAE的概率建模

VAE的概率建模

对于一个图像

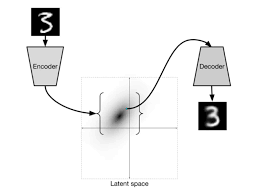

把这个隐空间学好了,就可以对于生成的东西有更好的操控

把

学好了,可以直接采样 ,这个分布很容易进行sample,首选还是多维高斯分布

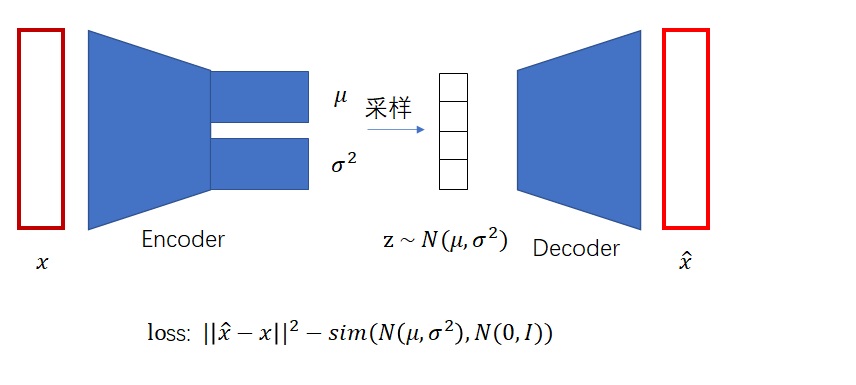

建模

- 生成式模型的概念建模方式

- 参数化单个样本

- VAE:

这个优化非常困难

- 参数化单个样本

- 生成式模型的概念建模本质

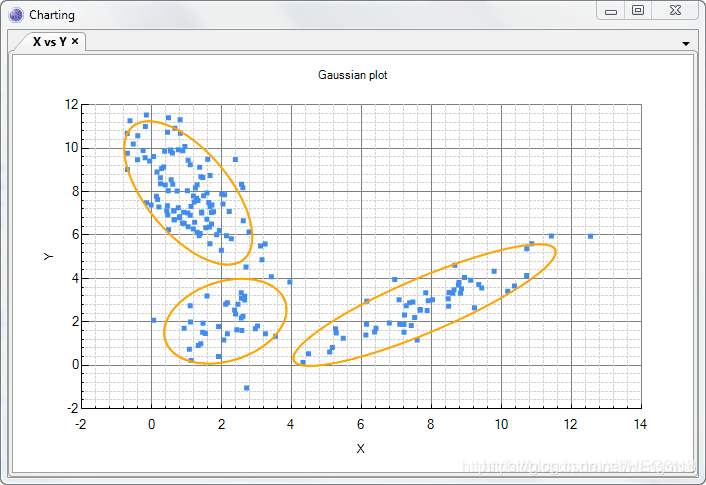

- 无数个高斯模型的混合

- 每个图像X,都有一个对应Z编码,再对应一个该图像的分布

- sample:

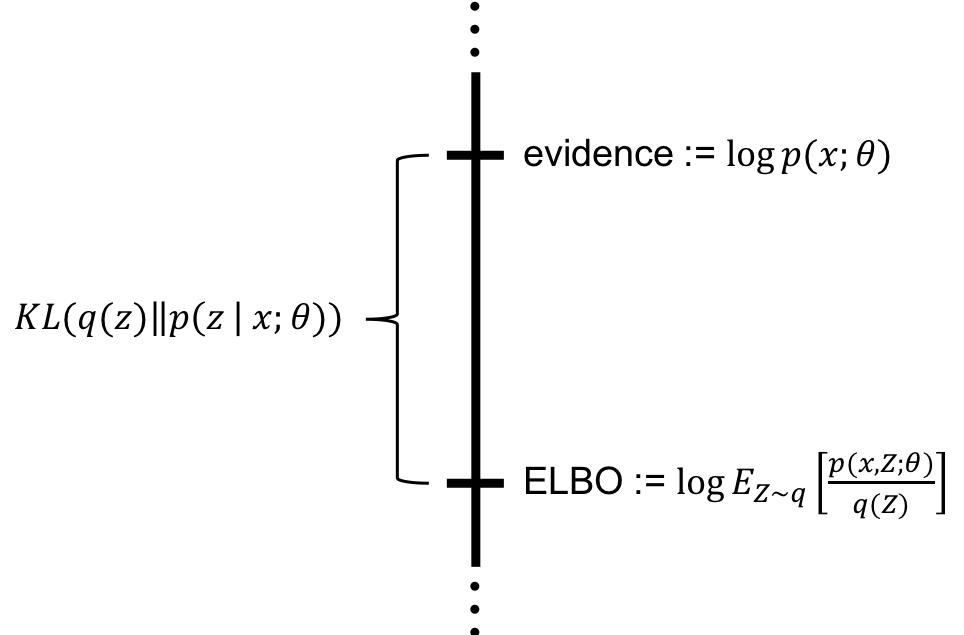

为何

log难以穿过积分号

既然难以计算,一种想法是通过蒙特卡罗方法来取近似,即从先验分布

中随机采样大量的 ,然后用 来近似这个积分,但是这么做的问题在于: 是一个非常简单的分布(如标准正态分布),但能够生成有意义图像 的 向量,在整个 的空间里只占极小的、几乎可以忽略的区域,所以如果随机采样,会采样到大量的噪声 - 直接来 sample

, 的概率大多为0,导致模型一直 error 很大,很难拟合样本 - 模型学习不到有意义的东西

解决思路:我们要更加有效的

,最好使用 来 sample ,即通过后验分布 来采样。根据贝叶斯定理, 。这个后验分布代表了“给定一个数据样本 后,最有可能产生它的隐变量 是什么”,这样我们就能得到那些最可能生成 的有效 向量,从而使训练过程更有效 引入新的问题:

同样包含了难以计算的边际似然 ,因此无法直接求出 - 解决方案:引入一个新的、可处理的、参数化的神经网络模型

来近似 。这个 就是VAE中的编码器(Encoder)。它的目标是通过训练,让其输出的分布尽可能地接近真实的后验分布

- 解决方案:引入一个新的、可处理的、参数化的神经网络模型

我们实际计算的是

,这和之后的ELBO相印证

All articles on this blog are licensed under CC BY-NC-SA 4.0 unless otherwise stated.