KL散度

KL散度

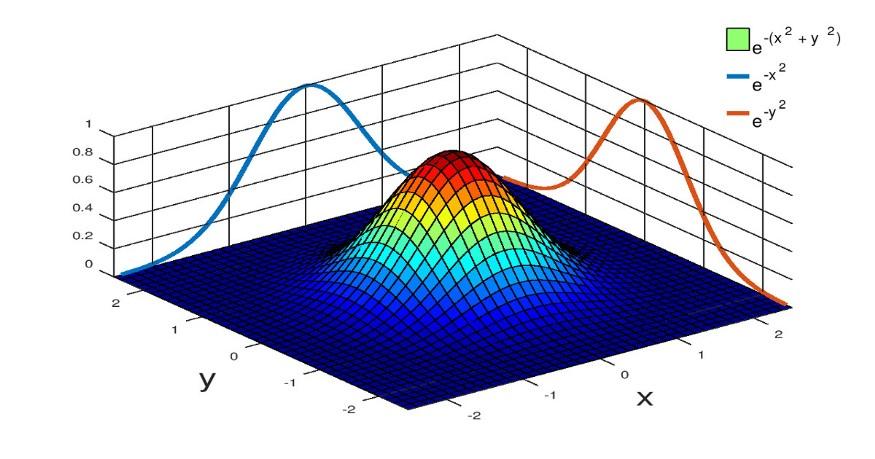

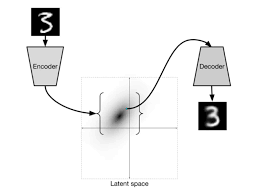

KL 散度(Kullback–Leibler divergence)是用来衡量两个概率分布之间差异的一种方法。它的数学表达式和理解可以分几个层次来看:

1. 数学定义

如果我们有两个概率分布

离散情况下:

或者连续情况下:

2. 核心直觉

非对称性:

所以它不是一个真正的“距离”,而更像是一种有方向的差异测量 非负性

当且仅当

(几乎处处相等)时取等号 不变性(Invariance under transformation)

如果

是单射(可逆)变换,则 意思是:在做变量的可逆变换时,KL 散度值不变

非负性证明

函数

同时

因此左边等于

所以

取等条件:Jensen 取等号当且仅当

不变性证明

若

假设

同理

计算

观察对数项:

因为 Jacobian 项在分子分母中抵消了。于是

对上式做变量替换

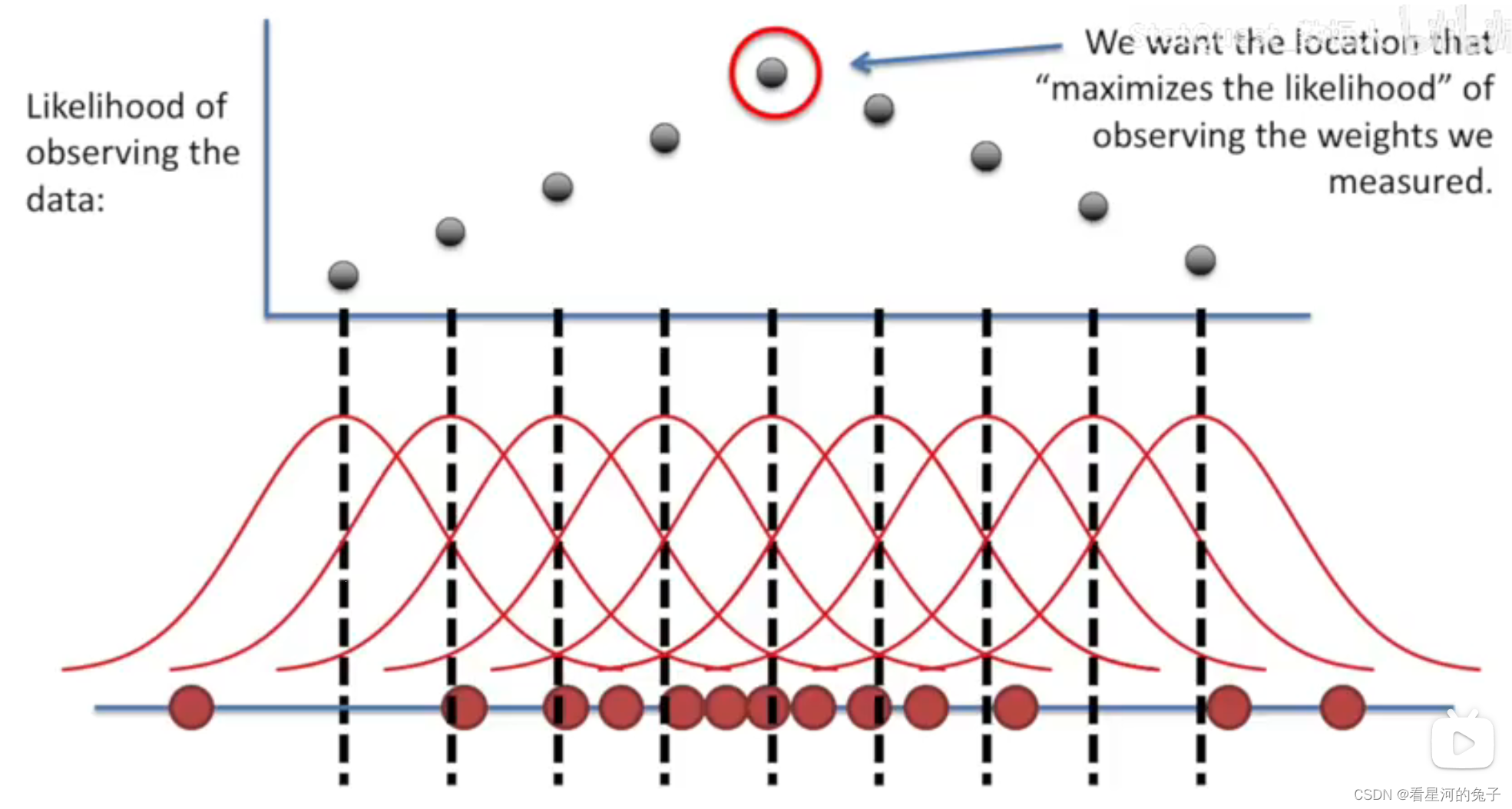

3. 信息论解释

在信息论中,概率分布

表示用最优编码描述来自

两者之差就是 KL 散度:

也就是说:额外浪费的比特数

4. 两个高斯分布的KL散度满足下面等式

设维度为

目标证明

多元高斯密度(对

KL 定义为(以

首先计算对数比(把常数项和二次型项分开):

因为

对

计算第一项

引理:

证明

展开左边:

又因为标量等于其迹,所以

把

对两边取期望,并把期望移进迹号(期望是线性算子,迹也是线性算子):

由协方差的定义

即对任意服从

因此第一项为

计算第二项

我们需要计算

把

第1项利用迹恒等式(同

第2项中

于是

注意

合并项得到最终公式

把前两步结果代回 KL 的表达式:

整理即得